Le concept d’intelligence artificielle ou IA a été introduit dans les années 50 par les mathématiciens et informaticiens John McCarthy et Marvin Lee Minsky, fondateurs du groupe d’intelligence artificielle du Massachusetts Institute of Technology (MIT)

L’IA peut être définie comme un « ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l’intelligence ». Il s’agit donc plus d’un courant de pensée protéiforme qu’une discipline homogène.

A l’interface des neurosciences, de l’informatique et de la logique, l’IA vise à produire des technologies capables d’imiter le comportement humain. A l’inverse d’algorithmes classiques où les réponses d’un programme sont prédéfinies par les concepteurs, une IA est capable de mettre en œuvre des processus cognitifs complexes comme l’apprentissage, l’adaptation à de nouvelles situations ou le raisonnement critique.

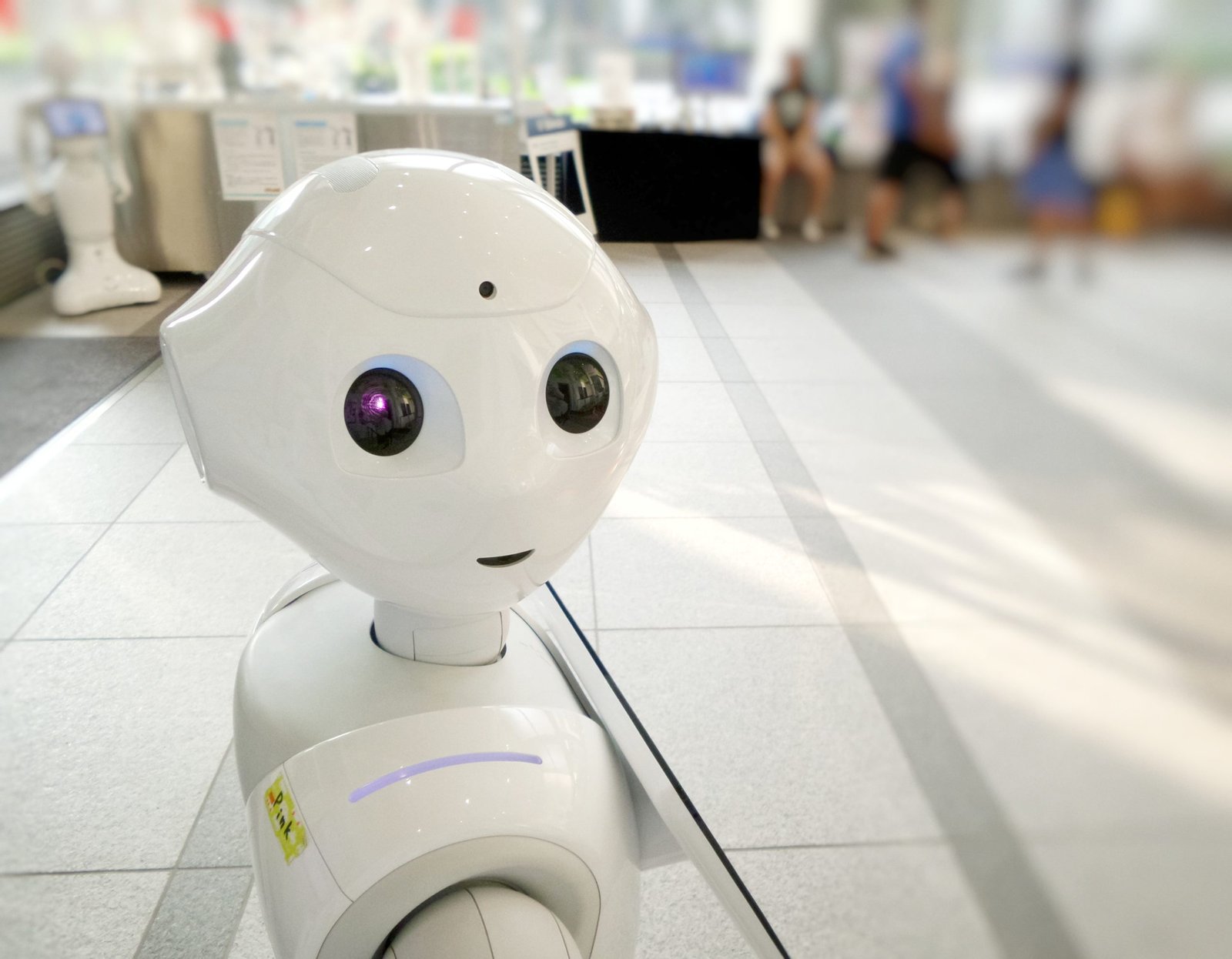

Longtemps considérée comme un objet de recherche de pointe, voire de science-fiction, l’IA commence aujourd’hui à atteindre un niveau de maturité suffisant pour commencer à diffuser progressivement dans nos vies quotidiennes. Elle est par exemple utilisée dans les assistants de nos smartphones, les enceintes connectées ou les SAV en ligne de nombreuses firmes.

L’IA : nouvel outil de management des organisations

Dans les organisations du travail, l’IA s’impose progressivement comme une solution innovante d’aide à la décision, de management de la productivité et d’amélioration continue. Le travail des employés peut ainsi être observé, analysé et rationalisé par des dispositifs « intelligents ».

Encore peu connues du grand public, ces pratiques commencent à être mises en lumière et leurs effets pervers sont parfois dénoncés.

Le géant mondial de la restauration Domino’s Pizza expérimente par exemple une technologie robotisée : le « Dom’Pizza Checker ». Elle permet d’analyser en temps réel le travail des employés afin d’améliorer chaque geste et de vérifier la conformité des produits tout en les améliorant continuellement.

Le géant de la distribution en ligne Amazon a également été critiqué en 2019 pour avoir expérimenté une IA analysant la performance des employés et identifiant sans intervention humaine les individus à licencier.

Dans ces exemples, il serait simpliste de mettre en cause l’IA. Cette dernière reste une solution technologique servant une finalité dont l’humain reste l’unique concepteur.

Le caractère autonome et adaptatif de l’IA pose cependant un véritable problème éthique. Construite pour imiter l’humain, une intelligence artificielle pourra devenir néfaste si elle n’est pas pourvue de référentiels éthiques dès sa conception. En 2016, un chatbot (robot conversationnel) apprenant lancé par Microsoft pour échanger avec des humains sur les réseaux sociaux a ainsi développé des comportements racistes en à peine quelques heures avant d’être mis en sommeil par ses concepteurs.

Le déploiement d’IA dans les organisations du travail appelle donc à la construction d’un cadre éthique permettant de doter tout programme autonome de garde-fous moraux lui interdisant toute décision allant à l’encontre de de l’intégrité des individus ou de l’intérêt général.

Quels effets pervers prévenir ?

David Leslie, Chercheur à l’Institut Alan Turing, a théorisé les bases de la conception d’une intelligence artificielle éthique.

Il a dans un premier temps identifié six grandes familles d’effets pervers pouvant découler de l’IA.

La discrimination : une IA bâtie pour optimiser l’organisation, la productivité ou le comportement pourra défavoriser des individus s’écartant d’un modèle d’efficience qu’elle aura défini, ouvrant la porte à des critères d’exclusion eugénistes (handicap, capacités physiques, âge, etc.).

Le déni d’autonomie et l’absence de voies de recours : La mise en œuvre de l’IA pour optimiser la performance peut réduire les degrés de liberté des individus. Il devient ainsi difficile de s’adapter de façon choisie et autonome aux prescriptions de l’organisation, et à fortiori de participer à la prise de décision. Le comportement des employés, jusqu’au registre émotionnel, risque d’être dicté de façon transgressive. Il sera par ailleurs très compliqué pour un employé d’engager des recours en cas de décision allant à l’encontre de ses intérêts si cette dernière n’est assumée que par une IA.

Le manque de transparence : Les critères sous-tendant les décisions d’une IA sont d’autant plus obscurs que celle-ci est capable d’auto-apprentissage. Contrairement à un algorithme classique, une IA pourra ainsi faire évoluer ses critères d’évaluation et de prise de décision de façon autonome. Cela rend très complexe la justification des décisions. Le risque de dilution des responsabilités en cas de problème est également alarmant.

La diffusion sur la sphère privée : Le recueil de données comportementales, démographiques ou biologiques par l’IA sans réelle possibilité de consentement des employés représente une violation de leur vie privée. Cette problématique est renforcée par le caractère autonome de l’IA : il est en effet difficile de savoir à l’avance de quelle façon les données seront analysées et quelles conséquences elles vont occasionner.

L’isolement et l’appauvrissement des soutiens : L’automatisation à outrance de la résolution de problèmes et des processus de prise de décision peut conduire à l’appauvrissement des interactions et à l’isolement des individus au travail. L’IA peut ainsi négliger l’utilité de la fonction sociale du travail et des interactions informelles, pourtant essentielles.

Le manque de prise en compte de l’intérêt général : Des processus entièrement gérés par l’IA peuvent conduire à des schémas de réponse stéréotypés, induisant progressivement un appauvrissement de la qualité globale du travail et du bénéfice économique et social qu’il procure. L’IA pourra également négliger l’impact sociétal ou environnemental des solutions qu’elle propose.

Dans ses travaux, David Leslie invite les concepteurs d’intelligences artificielles à questionner la dimension éthique de leurs créations au prisme de ces six familles d’effets pervers.

Leur anticipation permet d’implanter des garde-fous moraux dans les schémas cognitifs qui sous-tendront l’apprentissage et le processus décisionnel des IA.

Quels principes éthiques pour concevoir une IA ?

Selon David Leslie, toute IA devra être bâtie autour de quatre piliers éthiques clés :

Le respect de la dignité et de l’intégrité des individus : L’autonomie individuelle devra ainsi être respectée afin de préserver la latitude décisionnelle des individus. L’IA devra également être suffisamment transparente pour permettre à chacun de comprendre le processus décisionnel le concernant et offrir des voies de recours réelles. Les solutions d’optimisation qu’elle proposera devront également préserver la santé et le bien-être des individus dans une logique de performance durable.

Le soutien aux interactions humaines : Une IA éthique doit être pro-sociale. Elle doit ainsi favoriser l’expression de la solidarité et faciliter les interaction afin de prévenir l’isolement des individus.

L’intégration du cadre juridique et de l’intérêt public : La conception d’une IA doit intégrer les standards légaux internationaux en nationaux et ne pas permettre leur transgression. Une IA chargée de l’optimisation de la productivité devra ainsi intégrer les problématiques de prévention et de régulation de la charge de travail dans son processus décisionnel.

La recherche du bien-être individuel et collectif : L’IA ne peut négliger les impacts collatéraux résultat de son action. Elle gagnera ainsi à intégrer son impact sociétal et environnemental dans son processus d’apprentissage, de développement et de prise de décision.

En résumé, une IA éthique devra être conçue de façon à être dans l’incapacité d’apprendre, d’évoluer ou d’arbitrer en contrevenant à ces quatre familles de principes.

Quels enjeux futurs pour des IA éthiques ?

Même si les principes sous-tendant le développement d’IA éthique paraissent clairs, leur mise en œuvre réelle soulève de nombreuses problématiques opérationnelles.

Garantir l’implantation des principes éthiques implique en effet un véritable effort de transparence de la part des concepteurs.

La question du contrôle de la finalité des IA se pose également. Aujourd’hui, seuls les effets pervers observables à posteriori peuvent être mis en cause. Autrement dit, une IA néfaste mais discrète peut œuvrer en toute quiétude.

Idéalement, des mécanismes de contrôle à priori opérés par des acteurs indépendants dès la conception des IA seraient nécessaires. La diffusion de l’IA dans les organisations du travail exige par ailleurs une urgente évolution du droit du travail, un meilleur outillage des instances représentatives du personnel ainsi que l’attribution des moyens et des compétences nécessaires aux opérateurs publics (CNIL, DIRECCTE, etc.) exerçant une mission de contrôle.

La formation des concepteurs d’IA doit également s’enrichir pour intégrer des volets juridiques et éthiques.

Enfin, le développement de programmes d’information du public, et plus particulièrement des employés susceptibles d’être confrontés à l’IA dans leurs organisations du travail, permettrait d’enrichir le débat public pour une appeler à une utilisation plus raisonnée et responsable de l’IA dans les organisations du travail.

Pour en savoir plus : Guide pour le développement et l’implantation responsable de l’IA (ENG), Dr David Leslie, The Alan Turing Institute

0 commentaires